Как минимум, надо монтировать noatime!

Мы когда-то давно жили на reiserfs (из-за лимита на число inode в ext2), но он был глючен и тормоза усилялись со временем. У reiserfs было преимущество из-за наших файлов меньше 1кб. Пото начали переходить на ext3, в то время уже было много мелких файлов в среднем 1Кб, на ext3 начали ставить размер блока в 1кб и увеличивали число inode. Потом файлы стали бо'льшего размера, да и диски стали более емкие, перестали менять размер блока. Теперь только стоковый ext4 с дефолтными настройками блоков/inode, монитруем defaults,noatime.

Люба ФС, со временем, любая ФС начинает тормозить (привет тем кто считает что дефрагментация не нужна на линухе). Причем, ФС может в тестах даже с реальными объемами показывать одни результаты, а через год работы -- совершенно другое распределение пьедестала.

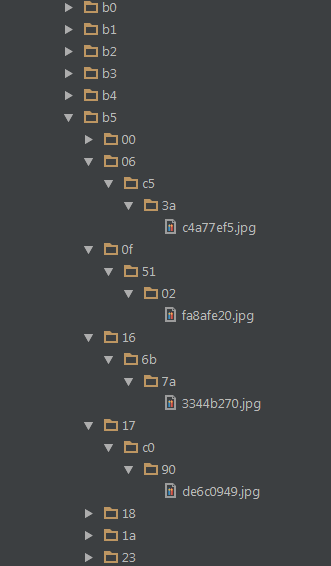

Там в ядре есть всякие блокировки объектов каталога при лукапах файлов, поэтому, чем больше файлов/каталогов внутри каталога, тем тормознее будет. Решение: разбивать многоуровнево по хешу от имени файла (см. ответ 65536 @65536).

Второй трюк: раз в полгода перезаливать данные. Если несколько разделов, перебрасываешь по кругу, переформатируя. Если один большой раздел, но нужен свободный сервер.