Привет. Ищу совета, информацию.

Сразу скажу, я не опытный админ, самоучка. Поэтому вопросы глупые, но как то надо вертется)

У нас небольшое производство, и небольшая серверная, которая собрана на старом железе, купленном на авито за копейки. (HP DL360G7, HP DL160G5, и даже такое kraftway es24)

Сейчас у меня появилась идея собрать маленькую схд, для серверов esxi + для бекапов.

Почему решил попробовать собрать СХД

У меня 2 сервера с ESXI HP DL360G7. Когда я их купил, то вставил обычные недорогие ssd. В каждом сервере 4 ssd на 250г, собранные в зеркальный рейд. Все завелось и заработало. Но с этим решением есть проблемы. Во первых очень маленькие скорости. Мне кажется даже на обычных hdd все работало бы быстрее. Вторая проблема, после правильного выключения сервера, у меня пропадают datastore в esxi, после нескольких перезагрузок появляются, и переходят в режим восстановления (если я это правильно понял). Один раз это привело к поломанной базе 1С, благо у меня были бекапы. Теперь я банально боюсь выключить сервера для того что бы их почистить от пыли.

Покупать sas диски от HP, мне никто не даст, да если честно я и сам не готов отвалить безумные деньги за все это.

Вторая причина сборки схд, это возможность переносить виртуальные машины с одного сервера на другой, что бы почистить от пыли, или что то про апгрейдить. (не уверен что так можно делать, но в теории думаю да)

Я попробовал на своем старом HP DL160G5 вставить обычный старый жесткий диск, установить truenas, и подключить его по ISCSI через обычный ethernet провод, через существующую локальную сеть. У меня все получилось, и я получил скорость больше чем на текущем решении. (возможно я не правильно это дело тестирую, но как есть)

Мои тесты

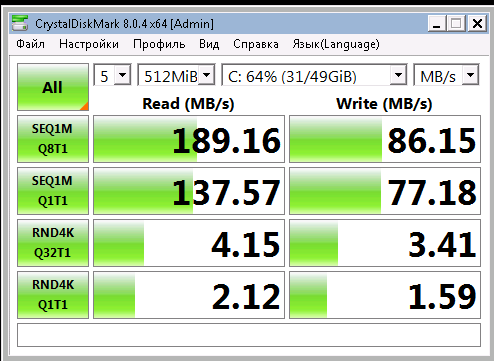

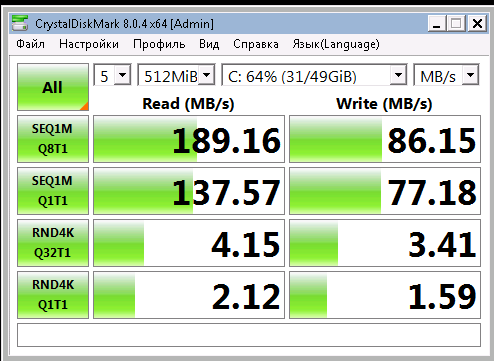

Это виртуалка на ssd которые стоят в сервере

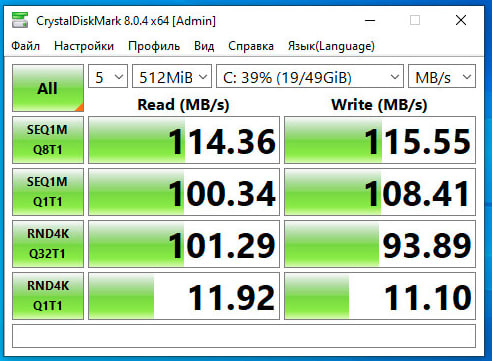

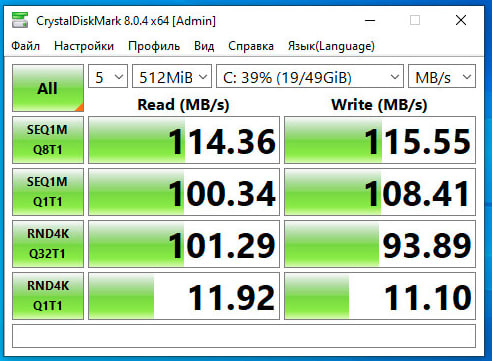

Это виртуалка на iscsi диске

Прошу совета как бы это все дело собрать на стареньком БУ железе, которое можно купить на авито, еще и с ценником 30-40к (без учета HDD). На что обратить внимание. Хочется что бы схд был всеядным и поддерживал hotplug для дисков, ну и что бы дружил с ssd. Из объемов максимум 2Тб Для виртуалок + примерно 500Гиг для бекапов.

Я хочу попробовать собрать на supermicro. Я так понимаю сервера этой компании никак не привязаны к вендорам. Правильно ли я понимаю что главное прикупить хороший современный контроллер который дружит с ssd?

Поставить truenas. Купить отдельный коммутатор и подключить все это обычным ethernet 1 gigabit в отдельной сети.

Поделитесь опытом или советом. Возможно у меня в голове каша, и много чего не понимаю, уже 2 дня гуглю этот вопрос.

p.s.

Попробую добавить информации о потребностях.

Сейчас работают 10 виртуалок на них небольшие базы MsSql и MySql, FreePbx для телефонии, zabbix, и вякая мелочь которая нужна для работы. Я предположу что нагрузка у меня минимальная. Но какая нагрузка в пике я не знаю. Бекапы базы данных я делаю каждую ночь, но базы маленькие до 1Гиг, поэтому нагрузка маленькая.