Есть скрипт, посылаю запросы через multi curl к сайту, в ответ, когда запросы выполнены он присылает call back. (каждый запрос он присылает отдельно, по одному ответу).

Когда происходит ситуация, что приходит 30-35 call backов одновременно скрипт запускается, делает обращение к базе, и через proxy начинает выполнять curl запрос, естественно он может висеть долго, т.к. делается через proxy.

Я слышал про

система очередей, но не совсем понимаю как это работает и поможет ли в моей ситуации.

Если эта самая система очередей просто откладывает выполнение запросов пока не выполняться предыдущие запросы, то боюсь это не подойдет мне, т.к. срок жизни того, что дает мне сайт через call back всего 2 минуты и я как можно скорее должен сделать запрос.

=====

Когда выполняются много call backов (они запускают curl запросы) при попытке обратится к phpmyadmin страница грузится минутами..., однако через filezila все работает быстро итд.

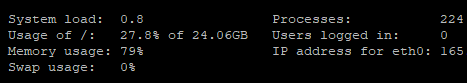

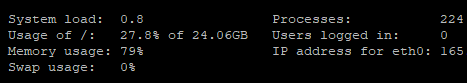

Ниже показываю как выглядит нагрузка:

Вопрос в итоге такой: Можно ли что-то сделать, или только не нагружать большим количество запросов пока не выполнились старые? Не хватает ресурсов или чего? Поможет ли в моем случае система очередей?

Вопрос в итоге такой: Можно ли что-то сделать, или только не нагружать большим количество запросов пока не выполнились старые? Не хватает ресурсов или чего? Поможет ли в моем случае система очередей?