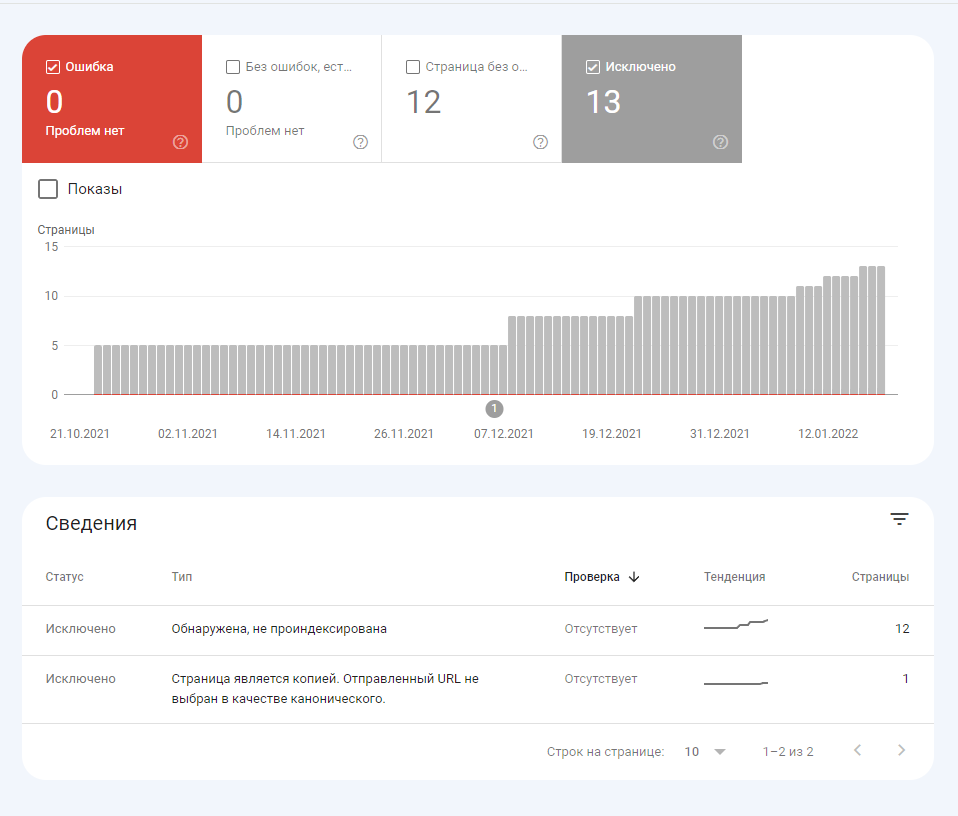

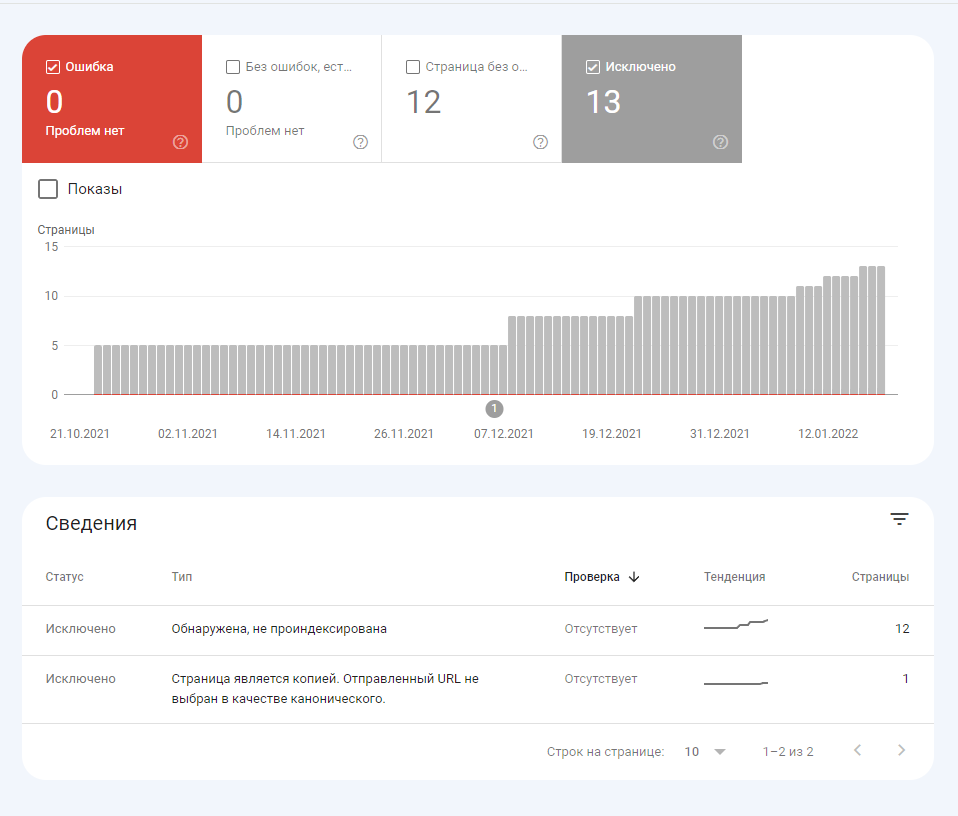

Доброго времени суток! В общем решил я как-то прикрутить блог на свой сайт. Проблема заключается в том, что Гугл наотрез не хочет вносить новые статьи в индекс *часть старых живут успешно ). Страницы блога в карте сайта видит, ошибки не находит - при ручном запросе на индексирование - вроде как пишет, что скоро все появится, но ничего не происходит. Тем временем в Яндексе все ок, все страницы успешно публикуются, довольно оперативно.

Рубрики - канонические. Сами статьи нет.

В robots.txt запретов никаких нет:

User-Agent: *

Host:

https://cliffe.ru

Sitemap: далее ссылка на карту

Сам блог здесь:

https://cliffe.ru/blog

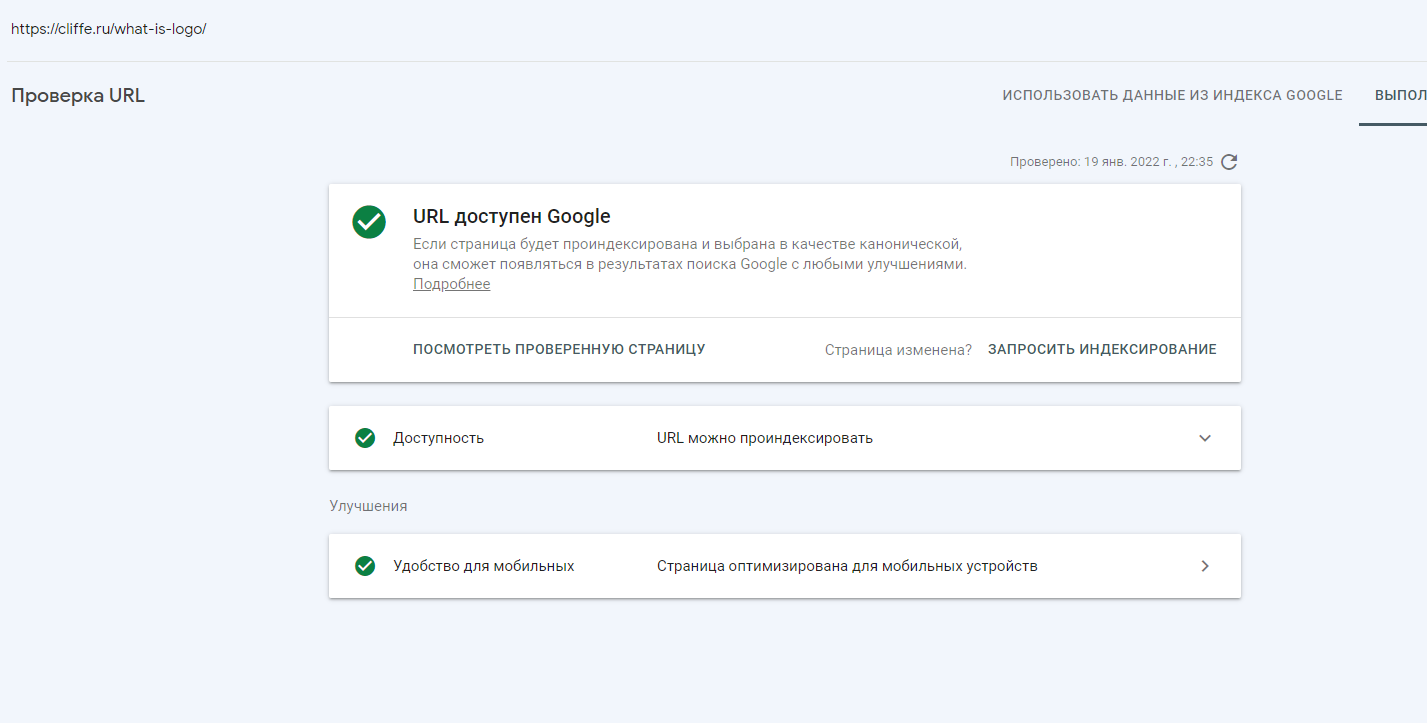

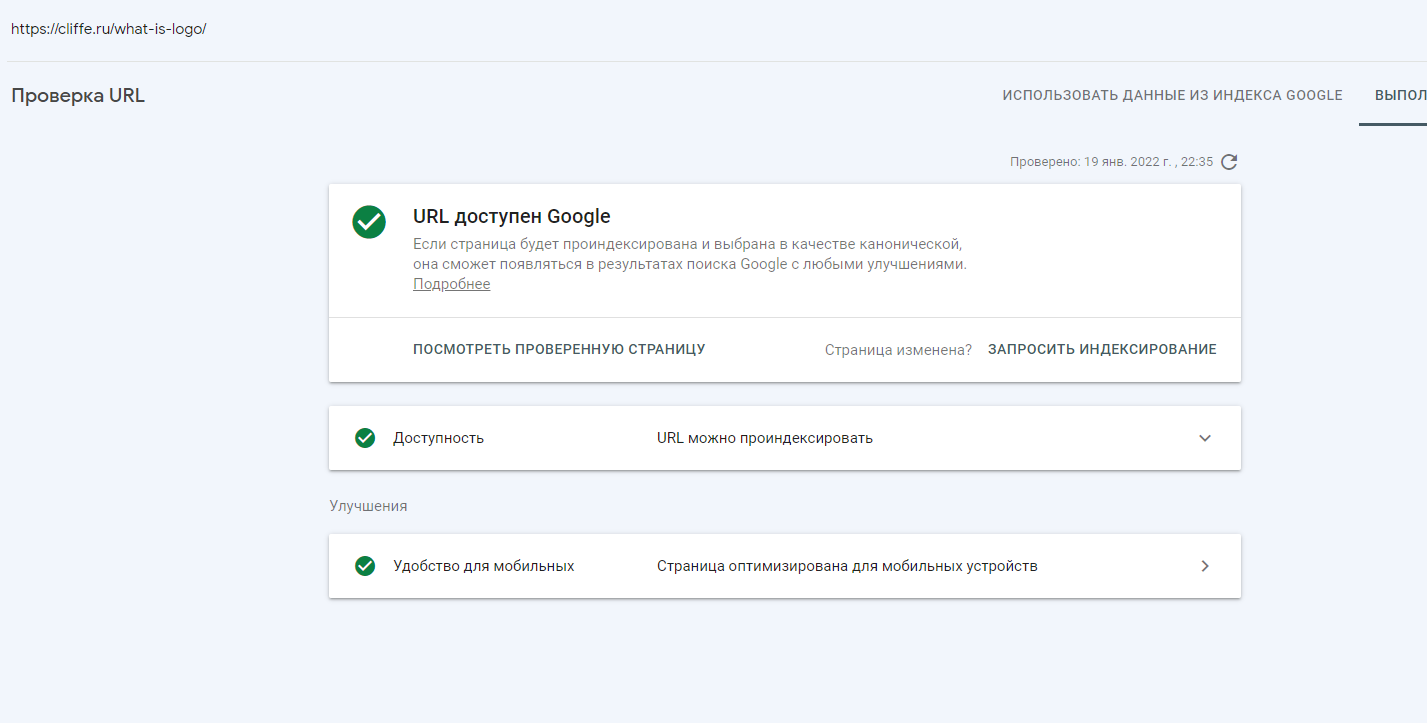

Товарищи знатоки, помогите советом пожалуйста. P.s. При нажатии на кнопку - проверить страницу на сайте - выходит следующее: