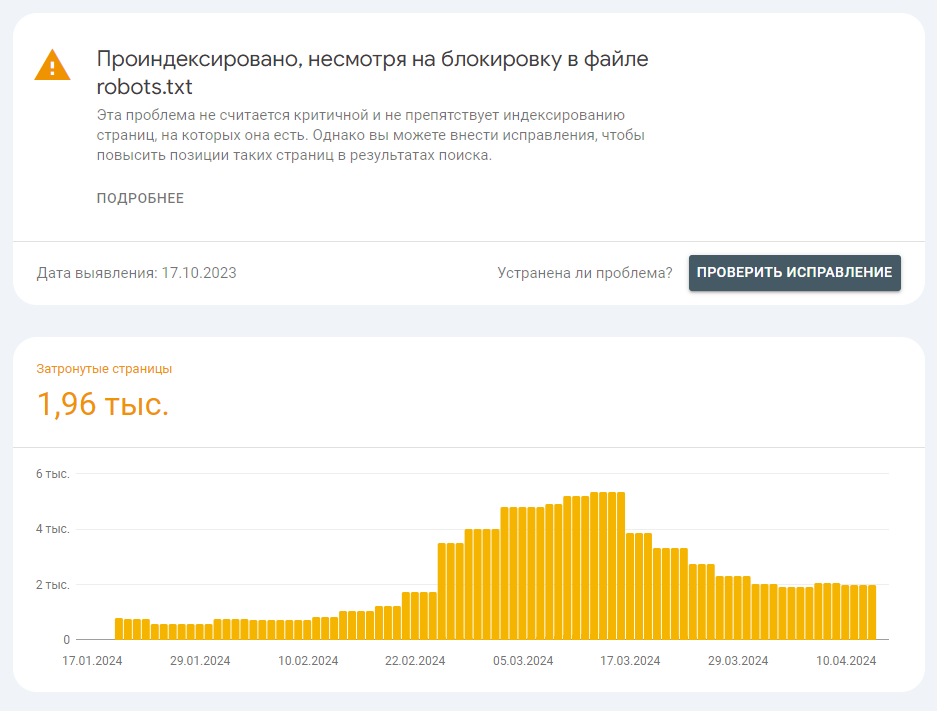

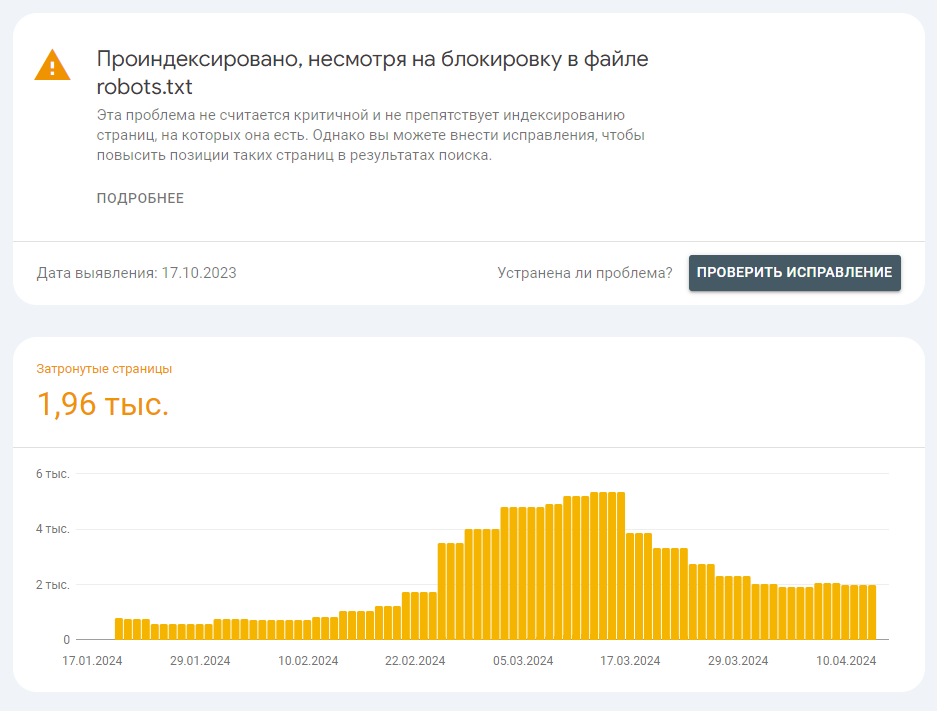

Здравствуйте, есть сайт на CMS: DLE. В панели вебмастера гугл очень много ошибок: "Проиндексировано, несмотря на блокировку в файле robots.txt", часть из них я исправил, но многие, возможно, не решены.

Ранее пытался убрать из индекса ссылки с помощью robots.txt, но понял, что это не решение. Наткнулся на X-Robots-Tag, глянул, что можно прописать в .htaccess, но для моего типа ссылок

https://сайт/index.php?do=download&id=56912 (любые цифры, ссылок много), это вариант не подходит. Ссылки ведут не на страницу, а на скачивание файла, при переходе просто скачается файл.

Нашел, что можно прописать в файле index.php, прописал:

X-Robots-Tag: noindex, nofollow

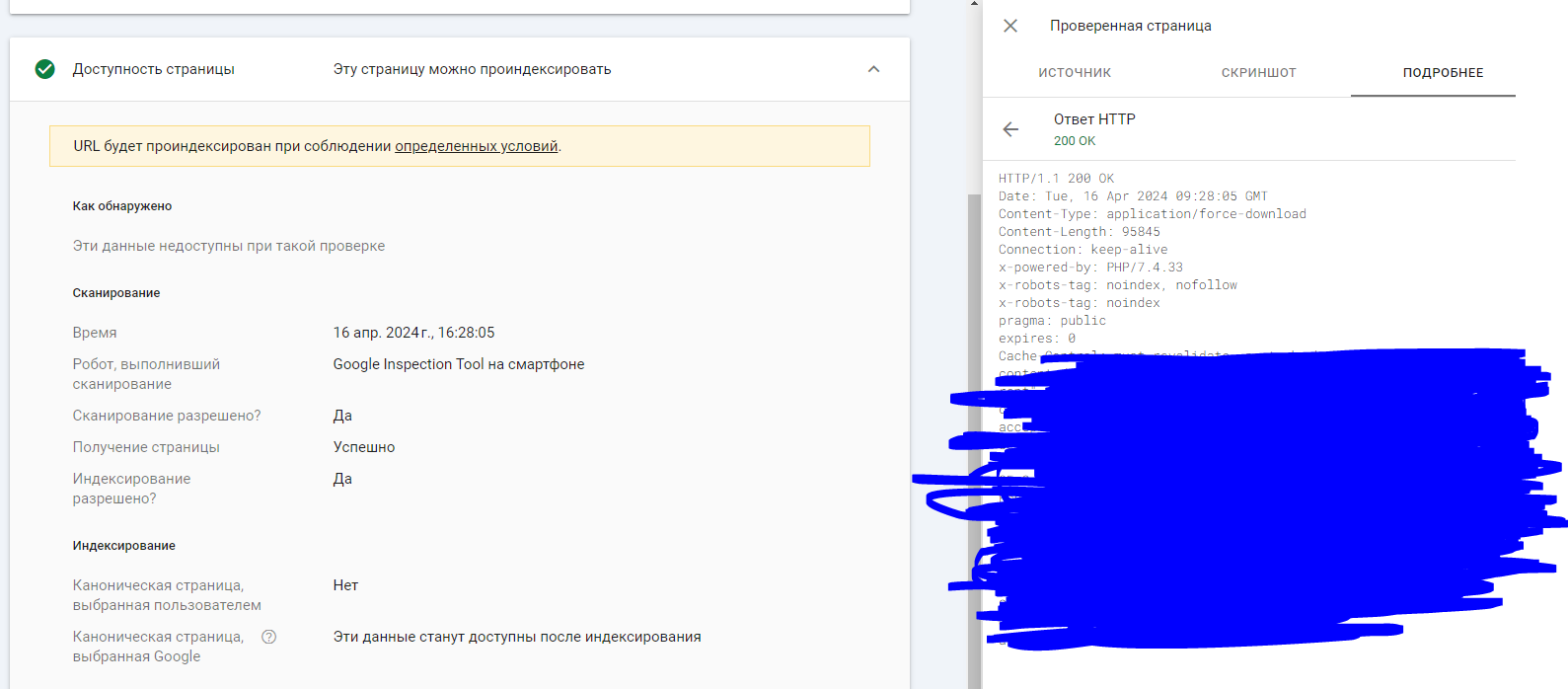

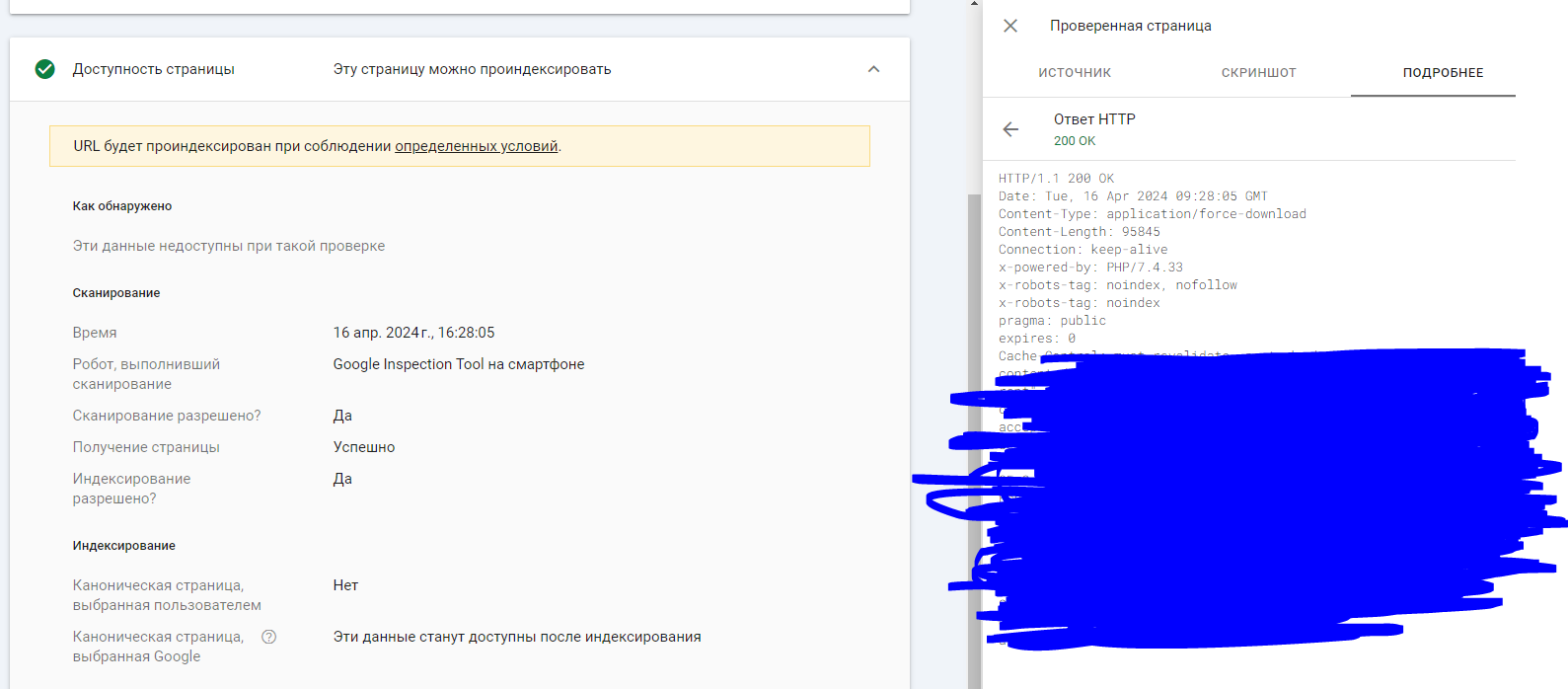

Но, почему-то, при проверке в вебмастере гугла любой из ссылок

https://сайт/index.php?do=download&id=56912

выдает, что индексирование разрешено, хотя тег X-Robots-Tag: noindex, nofollow проставлен в коде ответа http

Так и должно быть или нужно искать другой способ, чтобы убрать файлы из индекса?