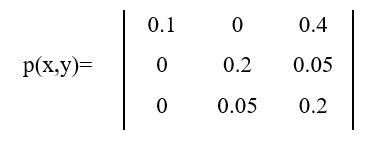

p(x,y) - это вероятность наступления события x и y вместе:

- Строки - это Xi

- Столбцы - это Yi

Т.е. если суммировать по 2 столбцу получишь априорную вероятность наступления Y2 - 0.25 (когда не знаем наступил ли Xi)

Теперь, переходим к формуле энтропии:

Проходишь по каждому элементу матрицы и рассчитываешь для него значение по этой формуле и суммируешь.

Конечно, обходишь значения нулевые, т.к. логарифм от 0 лучше не считать)

- p(x,y) - тебе известны, это значения матрицы

- p(y) - уже объяснял, это априорная вероятность наступления y (для каждого столбца он одинаков)

-(0.1 * log(0.1 / 0.1) + 0.4 * log(0.4 / 0.65) + 0.2 * log(0.2 / 0.25) + 0.05 * log(0.05 / 0.65) + 0.05 * log(0.05 / 0.25) + 0.2 * log(0.2 / 0.65)) - посчитаешь сам