Здравствуйте! Помогите, пожалуйста, разобраться.

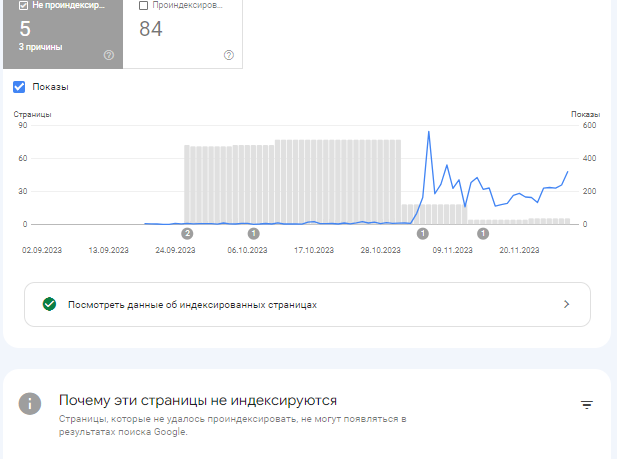

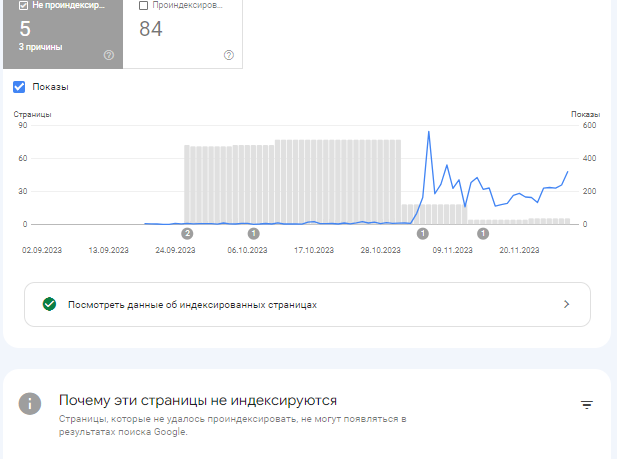

Всего на сайте 102 страницы.

Гугл проиндексировал 84 страницы, из них 5 не проиндексированны.

То есть он дает информацию о 89 страницах. Но остальные 13 нигде не показываются, и я даже не могу посмотреть, на каких страницах мне нужно исправлять что-то, чтобы они были проиндексированны.

Выглядит это вот так

и еще не понятно, почему требует canonical, я же исправила и дописала под стилями вот эту строчку:

<link rel="canonical" href="https://адрес-сайта.ru/">

Помогите, пожалуйста, разобраться, как найти эти страницы и исправить их.