Собственно есть хост с тяжелыми файлами и кучей дирректорий, фтп нет, только запароленный http, к которому доступ тоже скоро закончится.

Нужно срочно переместить всё это дело куда-то в облако, всего около 5ТБ.

Имеется впс с ссш и рдп, безлимитный гугл драйв учебный и триал дропбокса.

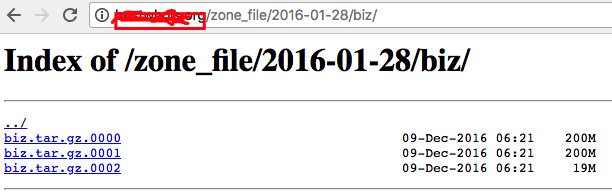

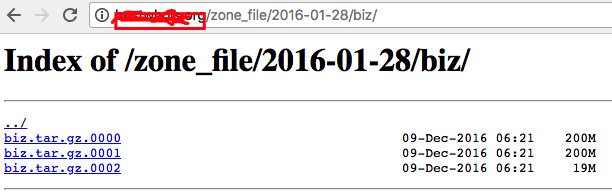

Конкретно нужны .tar.gz архивы, которые лежат в таких вот директориях:

./zone_file/2017-11-21/biz/

http://domain.com/zone_file/2016-01-28/biz/biz.tar.gz.0000

http://domain.com/zone_file/2017-11-21/biz/biz.tar.gz.0000

http://domain.com/zone_file/2017-06-29/net/net.tar.gz.0000

http://domain.com/zone_file/2017-06-29/net/net.tar.gz.0001

http://domain.com/zone_file/2017-06-29/net/net.tar.gz.0002

От 1 до 18 частей архивов в директории.

Есть полный список дат-папок вроде /2017-06-29/

И начала имени архива и части директории по типу /biz/

По сути 2 переменные и они известны.

Ещё есть html'и с содержимым директорий, из них можно получить названия файлов архивов.

Видится так, что нужно сгенерировать пути к хтмл, из существующих спарсить имена архивов.

Сохранить ссылки в список/списки, который затем впс с помощью wget/curl/bash перельет в облако, создавая находу директорию и имя файла из урла, чтобы потом не разбирать полную кашу в облаке.

К примеру 20170629net.tar.gz.0000

<html>

<head><title>Index of /zone_file/2017-06-29/net/</title></head>

<body bgcolor="white">

<h1>Index of /zone_file/2017-06-29/net/</h1><hr><pre><a href="../">../</a>

<a href="net.tar.gz.0000">net.tar.gz.0000</a> 29-Jun-2017 19:50 200M

<a href="net.tar.gz.0001">net.tar.gz.0001</a> 29-Jun-2017 19:55 164M

</pre><hr></body>

</html>

/zone_file/status/supported_tlds

xn--tckwe,xn--tiq49xqyj,xn--unup4y,zappos,zara,zero,zippo,zip,zone,zuerich,..

Index of /zone_file/

2016-01-13, 2016-01-14, ..., 2018-04-22