По умолчанию ls не только читает каталог, но и делает stat на каждый файл, чтобы цветом показать их тип и executable bit. Это очень замедляет процесс.

Обойти вызовом ls без параметров, заданных в alias ls:

$ alias ls

alias ls='ls --color=auto'

$ ls # вызывает алиас

$ 'ls' # вызывает обычный ls без параметров

Но лучше не выводить в консоль (особенно если сервер открыт по сети) - это будет очень долго - а перенаправить в файл и потом просмотреть.

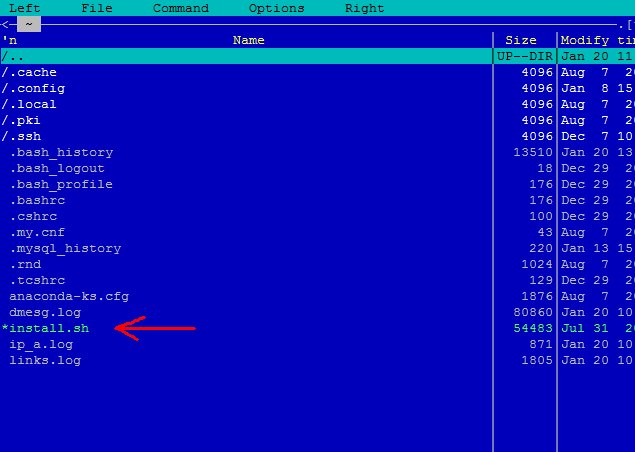

'ls' /root > /tmp/list_of_files

less /tmp/list_of_files

Удалить файлы проще всего с помощью find:

find /root -name 'index.html.*' -delete