О том что параметр Clean-param не воспринимается гуглом, уже писалось и не раз (и на самом Яндексе тоже). С этим все понятно. Но как быть, если я хочу использовать robots.txt И для google И для Яндекс

одновременно (да и вообще любых прочих ПС)?

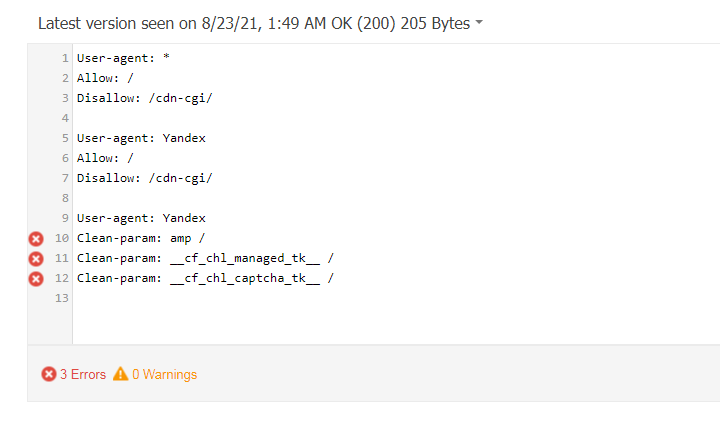

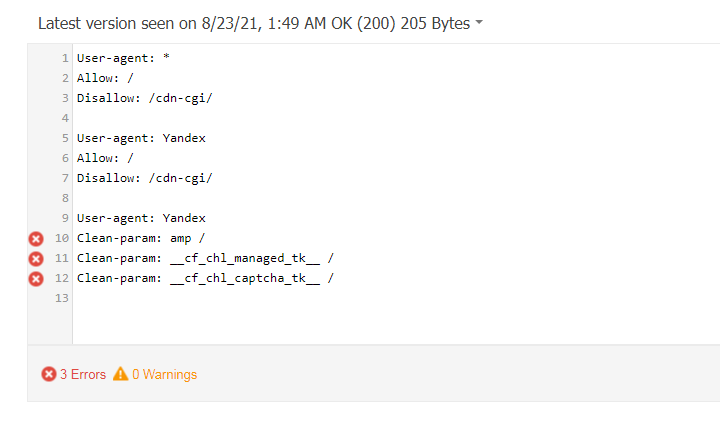

Вроде бы существует директива, делящая на секции файл robots.txt, позволяющая задать параметр исключительно для Яндекса. Но при проверке утилитой от Google он генерирует ошибку (Яндекс же считает этот файл корректным):

Как я ни пробовал (менял секции, объединял их, менял местами), мне не удалось сделать так чтобы обе поисковые системы приняли этот файл и посчитали бы его корректным.

Возможен конечно вариант, когда я на сервере буду определять бота, который запрашивает файл и отдавать ему разные варианты, но это же очень неудобно, да и под все боты не напишешь правил. Так, например, сервис SemRush тоже не принимает такой файл. И думаю, большинство других сервисов так же, ибо этот параметр воспринимается только Яндексом.

Кто-нибудь использует параметр Clean-param на своих сайтах и использует одновременно И Google Webmaster Tools И Yandex.Webmaster? Как вы боретесь с ошибками (в Яндексе) дубликатов страниц с "ненужными" параметрами?