Доброго времени суток.

Прохожу на Stepik курс по machine learning и столкнулся с довольно неприятной проблемой.

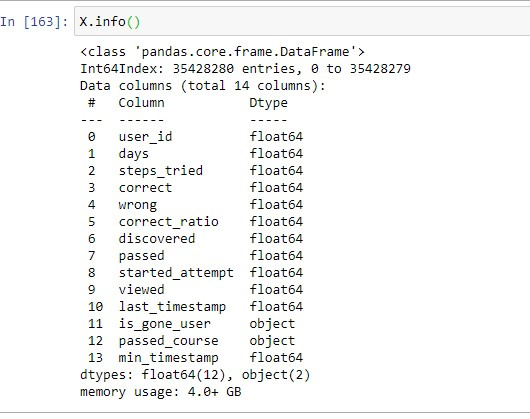

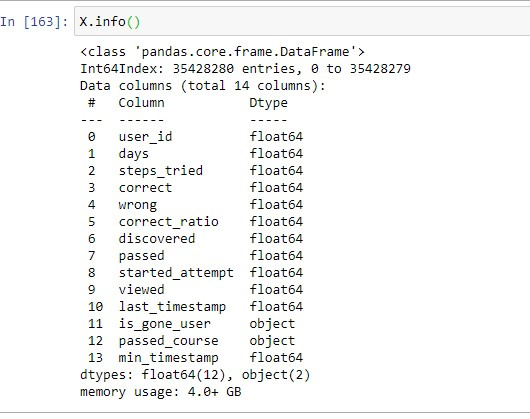

Во время подготовки данных конечный датафрейм разросся до небывалых размеров

Есть ли какая-то возможность оптимизировать использование ресурсов компьютера, а то работать невозможно. При запуске ячейки комп просто зависает. Даже для того, чтобы вывести сообщение на скриншоте компьютер довольно сильно залагал.

Комп имеет старенький intel core i3 и 8гб ddr3. Или всё-таки надо менять комплектующие?