Робот зайдет везде, куда только можно зайти и проиндексирует все что не запрещено.

А то что запрещено тоже проиндексирует, просто это не будет участвовать в поиске, и он не будет строить снипеты.

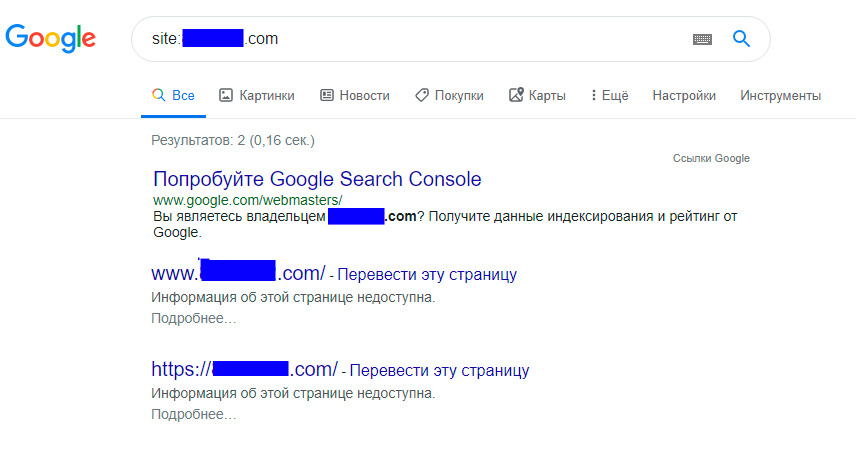

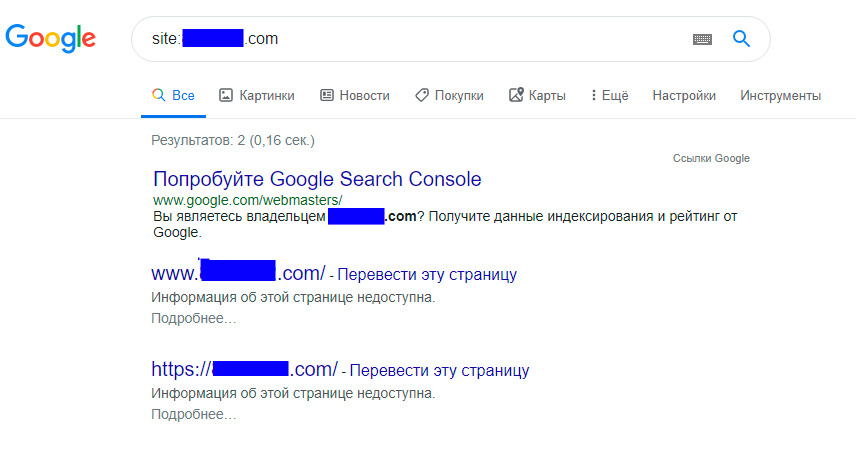

И чтобы не быть голословным, вот сайт у которого robots.txt вот такой. То бишь запрещено все:

User-agent: *

Disallow: /

Гоша его прекрасно проиндексировал, но не создал снипетов. Скрин

Ну, а теперь документация, цитата: "Файл robots.txt сообщает поисковым роботам, какие страницы или файлы на вашем сайте можно или нельзя обрабатывать. Используйте его, чтобы ограничить количество запросов, которые получает ваш сервер, и снизить нагрузку на него.

Этот файл не предназначен для того, чтобы запрещать показ веб-страниц в результатах поиска Google. Если вы не хотите, чтобы какие-либо материалы с вашего сайта были представлены в Google, применяйте директивы noindex. Также вы можете создать на сайте разделы, защищенные паролем."

https://support.google.com/webmasters/answer/60626...