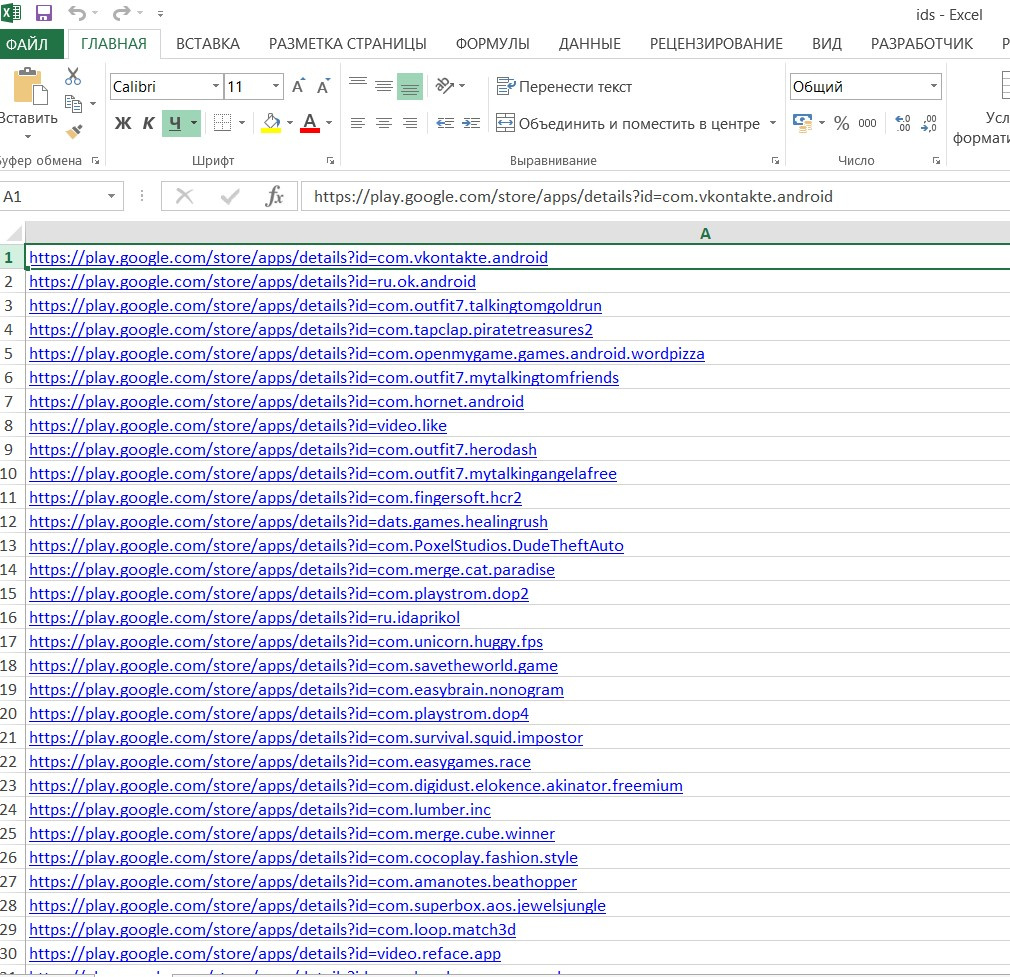

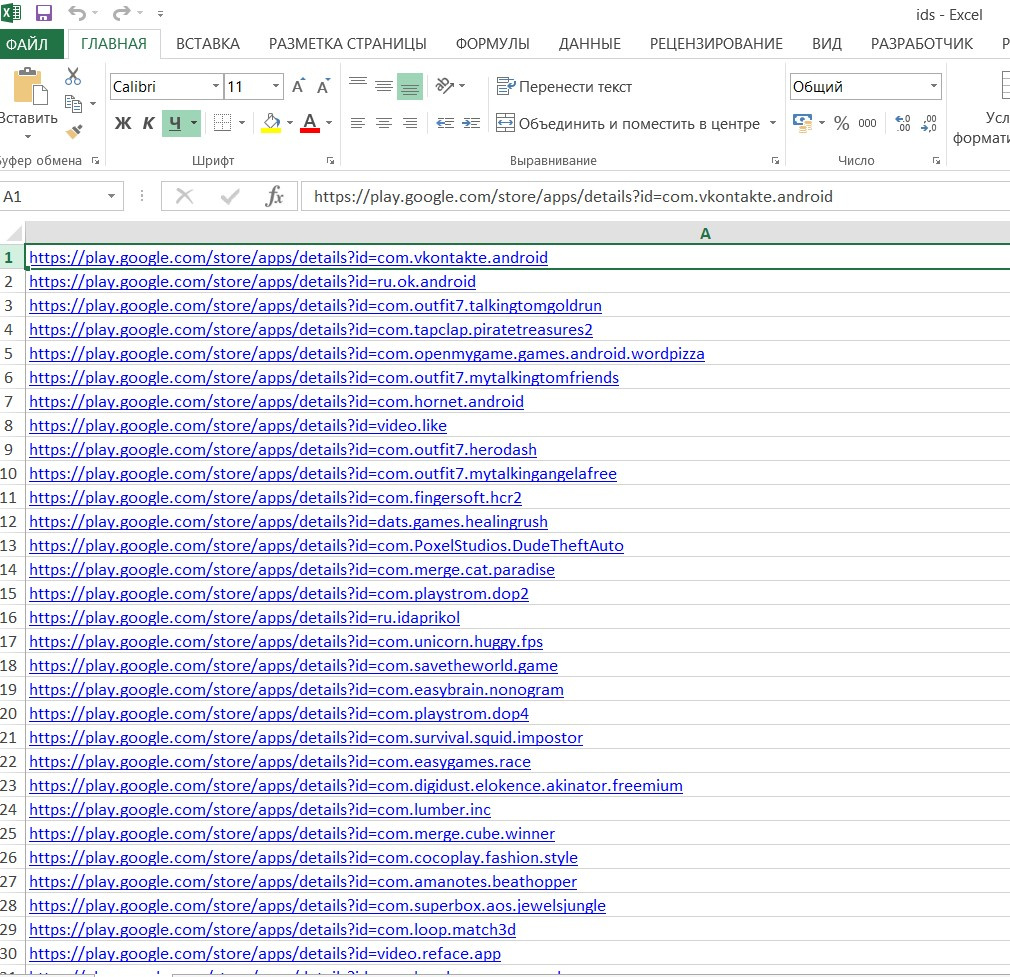

Есть экселевский файл, который содержит ссылки в одном столбике.

Как правильно вытащить название приложений, которые он выдает по ссылкам?

Пример файла на картинке:

Продублирую сюда часть ссылок из списка:

https://play.google.com/store/apps/details?id=com.vkontakte.android

https://play.google.com/store/apps/details?id=ru.ok.android

https://play.google.com/store/apps/details?id=com.outfit7.talkingtomgoldrun

https://play.google.com/store/apps/details?id=com.tapclap.piratetreasures2

https://play.google.com/store/apps/details?id=com.openmygame.games.android.wordpizza

https://play.google.com/store/apps/details?id=com.outfit7.mytalkingtomfriends

https://play.google.com/store/apps/details?id=com.hornet.android

Образец моего кода:

import requests

from bs4 import BeautifulSoup

import pandas as pd

df = pd.read_excel('ids.xlsx')

url = df

for urlibs in url:

response = requests.get(urlibs)

soup = BeautifulSoup(response.text, 'lxml')

quotes = soup.find_all('h1', class_='AHFaub')

for quote in quotes:

print(quote.text)

При моём коде выдаёт только первую строчку, а как можно получит все строчки?